העדכון האחרון של כלי מנהלי האתרים של גוגל הבטיח לעשות סדר ברשימת השגיאות שמזוהות באתרי אינטרנט , ולהפוך אותן למתומצתות וברורות יותר. אם בעבר היינו מקבלים בבת אחת רשימה של כל הבעיות באתר, הרי שמעכשיו נראה קודם כל רק את הבעיות הכי קריטיות שאפשר לטפל בהן מיד. סיכום של השגיאות מופיע גם על גבי ציר זמן , כך שאפשר לדעת אם יש מגמת שיפור, דריכה במקום, או מגמה של החרפה (יותר ויותר שגיאות מתגלות).

ולמרות הניסיונות של גוגל לעשות סדר בדברים, יש עדיין לא מעט מקדמי ובוני אתרים שלא יודעים מהי המשמעות של כל שגיאה ומה בדרך כלל מומלץ לעשות בנידון. יש גם כאלו שטוענים שדווקא השינוי הזה גרם לכך שבעיות אחרות, כמו קבצים ספציפיים שנחסמו על ידי קובץ robots.txt לא מופיעות יותר בגלל ההחלטה של גוגל לתת יותר עדיפות לשגיאות ברמת האתר כולו.

המדריך הנוכחי המורכב משני חלקים (אחד בשבוע הזה ואחד בשבוע הבא) נכתב במטרה לעשות קצת סדר בדברים ולהפריח כמה מיתוסים. אז בואו נתחיל:

עמודים שלא נמצאו :

שגיאות של עמודים שלא נמצאו מתחלקות לשניים :

- עמודים שמחזירים שגיאת 404 מהשרת

- עמודים חסרי תוכן שנראים כמו עמוד שגיאה, אבל לא מחזירים קוד מתאים (נקרא soft404).

הדבר הראשון שצריך להבין הוא שהדרך של גוגל לדווח על עמוד שלא נמצא היא באמצעות זיהוי קישור המוביל לאותו העמוד. כתוצאה מכך, אנחנו עלולים להיתקל בעמודים שכלל לא קיימים באתר. העמודים האלו דווחו כי מישהו קישר אליהם בצורה לא נכונה.

לכן, כאשר אנחנו בודקים מהו מקור הקישור הזה ("קושר מ"), עלינו לבדוק האם מדובר בקישור שיוצא מהאתר שלנו או קישור מאתר חיצוני. אם הקישור הוא מהאתר שלנו, ייתכן שיש לנו שגיאת כתיב או שאנחנו מקשרים לעמוד ישן שפשוט לא קיים. בכל מקרה, רצוי לתקן את הקישור בהקדם או להסיר אותו .

אם לעומת זאת, מדובר בקישור מאתר אחר, לנו אין בדרך כלל את היכולת לשנות את הקישור בעצמנו, ועלינו ליצור קשר עם בעל האתר. יש גם הרבה אתרים שמעתיקים תכנים של אתרים אחרים ויוצרים קישורים שבורים, ובמקרה הזה, מוטב לעזוב אותם לנפשם, אלא אם כן מדובר בהעתקת תכנים מסיבית. הסיבה היא שתיקון הקישורים האלו בדרך כלל לא שווה את המאמץ, והמחשבה שגוגל מעניש כל אתר שיש בו קישורים שבורים אינה בהכרח נכונה (אחרת היה קל מדי להפיל אתרים).

מעבר לתיקון או מחיקת קישורים, עמודים שמחזירים קוד שגיאה תקין (404) או נחסמים על ידי קובץ robots.txt, ניתנים למחיקה מיידית מהאינדקס של גוגל באמצעות שליחת בקשה מיוחדת לגוגל דרך כלי מנהלי האתרים.

בעיה עם קובץ robots.txt

Robots.txt הוא הקובץ דרכו אנחנו מורים לגוגל איזה דפים באתר שלנו לסרוק. אם אין קובץ כזה, גוגל מרשה לעצמו לסרוק את כל האתר.

מעבר לתחביר שגוי שיכול לגרום לשגיאות, אחת השגיאות הכי נפוצות נוצרת כאשר בעלי אתרים בודקים אתר לפני עלייתו לאוויר וחוסמים את הרובוט בגוגל בכוונה, על מנת שלא יתחיל לאנדקס אותו. לאחר מכן, הם פשוט שוכחים למחוק את השורה Disallow / מהקובץ. השורה הזו אומרת לרובוט של גוגל שלא יבקר בכלל באתר , ולכן שום עמוד ממנו לא מופיע בתוצאות החיפוש. השגיאה הזו נפוצה במיוחד במקרים בהם בונים הרבה אתרים בבת אחת.

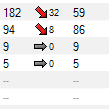

שגיאות DNS או שרת

שגיאות DNS בדרך כלל מתרחשות כאשר גוגל לא מצליח ליצור קשר עם השרת של האתר במשך מספר פעמיים. באתרים המאוחסנים בחברת אחסון אמינה זה לא אמור לקרות, אבל אם חברת האחסון לא יציבה במיוחד והשרתים שלה נופלים לעיתים קרובות, בהחלט ייתכן שגוגל ידווח על השגיאות האלו.

אם השגיאות האלו נמשכות זמן רב ובמקרים קיצונים בהם כל האתר לא עולה למשך מספר ימים, גוגל יסיר אותו בסופו של דבר מהאינדקס, דבר שהוא בעצם תסריט הבלהות הכי גדול של כל מקדם אתרים או בעל אתר.

מומלץ לא לשחק יותר מדי עם שגיאות DNS ולפנות ישירות לחברת האחסון.

בשבוע הבא נדבר על סוגי שגיאות נוספות. כמובן שנשמח אם תעירו בתגובות לגבי מידע נוסף שיש לכם אודות סוגי השגיאות שהצגנו הפעם הזו.

כדאי לצפות על דף 404 מתוכנן:

השאירו תגובה

Want to join the discussion?Feel free to contribute!